VALORANT-Reihe: Gesundheit von Systemen – Toxizität im Sprach- und Textchat

Dieser Artikel ist Teil einer Reihe, die zu Themen zu gewerteten Systemen und sozialem Verhalten und Spielerbenehmen in VALORANT ins Detail geht. Mehr über diese Reihe erfährst du hier.

Hallo nochmal! Sara und Brian von den Teams für soziales Verhalten und Spielerbenehmen in VALORANT melden sich wieder mit Neuigkeiten über unsere geplante Arbeit. Jetzt wird’s knifflig, also stürzen wir uns am besten gleich rein. Heute sprechen wir über Missbrauch von Kommunikation in VALORANT und wie wir dagegen vorgehen wollen.

EINFÜHRUNG – DER WEG ZUM PROBLEM

Toxizität in der Kommunikation umfasst, was wir im Sprachchat und im Textchat des Spiels als unerwünschtes Verhalten betrachten. Wir können natürlich schlechtes Verhalten einiger Spieler nie ganz verhindern, aber wir können daran arbeiten, Verhalten wie Beschimpfungen, Bedrohungen, Belästigung oder beleidigende Sprache durch unsere Spielsysteme zu bekämpfen. Außerdem können wir positives soziales Verhalten ermutigen.

Wie wir bereits besprochen haben, wollen wir in Bezug auf Toxizität bei Kommunikation im Gaming eine Vorreiterrolle einnehmen und für eine bessere Zukunft kämpfen. In diesem Bereich gab es unserer Ansicht nach schon vielversprechende Fortschritte, es gibt allerdings noch viel zu tun.

Es gibt zwar kein Allheilmittel, aber wir möchten dir einige der Schritte erklären, die wir unternommen haben (und die daraus gemessenen Resultate) und über Schritte sprechen, mit denen wir in Zukunft das Erlebnis im Sprach- und Textchat von VALORANT verbessern wollen.

WAS HABEN WIR BISHER GEMACHT?

Sprechen wir zunächst darüber, was wir bisher gemacht haben. Wenn es um unerwünschte Kommunikation in unserem Spiel geht, verlassen wir uns auf zwei wichtige Arten der Erkennung.

Feedback von Spielern

Die erste Art der Erkennung ist das Feedback von Spielern – insbesondere Meldungen! Einer der Gründe, warum wir alle Spieler ermutigen, schlechtes Verhalten zu melden (egal, ob jemand den Chat missbraucht, AFK ist oder absichtlich verliert), ist, weil wir diese Daten aktiv aufzeichnen und für Strafen verwenden.

Wir möchten klarstellen: Das bedeutet nicht, dass jeder gemeldete Spieler eine Strafe erhält – wir suchen nach Wiederholungstätern und verhängen immer höhere Strafen, von Verwarnungen bis hin zu permanenten Sperren (bei besonders schlimmen Vergehen).

Als wir über AFK in VALORANT gesprochen haben, haben wir „Verhaltenswertungen“ erwähnt. Ebenso haben wir für jeden Spieler in VALORANT eine interne „Kommunikationswertung“ erstellt, damit wir uns schnell um Wiederholungstäter kümmern können.

Gleichzeitig gibt es einige Dinge, die Spieler in unserem Spiel tippen und sagen, die wir als „Null-Toleranz-Verstöße“ betrachten. Diese Dinge zeigen uns eindeutig, dass wir Spieler, die so etwas sagen oder tippen, einfach nicht in VALORANT haben wollen. Wenn wir Meldungen zu solchen Ausdrücken erhalten, gehen wir sofort zu harten Strafen über. (Aktuell werden diese Strafen nach dem Ende eines Matches ausgesprochen – mehr dazu später.)

Liste stumm geschalteter Wörter

Wie du vielleicht bereits erlebt hast, ist die automatische Texterkennung nicht perfekt (Spieler haben ziemlich „kreative“ Weisen gefunden, unsere Systeme zu umgehen), also kann es zu Fällen kommen, in denen „Null-Toleranz-Wörter“ nicht erkannt werden. Aus diesem Grund haben wir vor kurzem eine „Liste stumm geschalteter Wörter“ implementiert, mit denen du manuell Wörter und Sätze rausfiltern kannst, die du nicht im Spiel sehen willst.

Das hat zwei Funktionen:

Erstens wissen wir, dass unsere automatischen Erkennungssysteme nicht perfekt sind, also wollten wir dir die Möglichkeit geben, selbst unerwünschte Kommunikation im Spiel rauszufiltern. Zweitens wollen wir die Wörter, die du auf deine Liste stumm geschalteter Wörter gesetzt hast, in zukünftigen Versionen unseres Systems in unsere automatische Erkennung aufnehmen (also verbesserst du unsere automatischen Erkennungssysteme, wenn du die Liste stumm geschalteter Wörter verwendest!).

WELCHE RESULTATE HABEN WIR GESEHEN?

Bis jetzt haben wir dir einige der Dinge erklärt, mit denen wir Toxizität in VALORANT feststellen, bestrafen und verhindern. Das ist nur die Spitze des Eisberges und es liegt noch eine lange Reise vor uns. Sehen wir uns also einige der Ergebnisse unserer Handlungen an.

Stummgeschalteter Chat

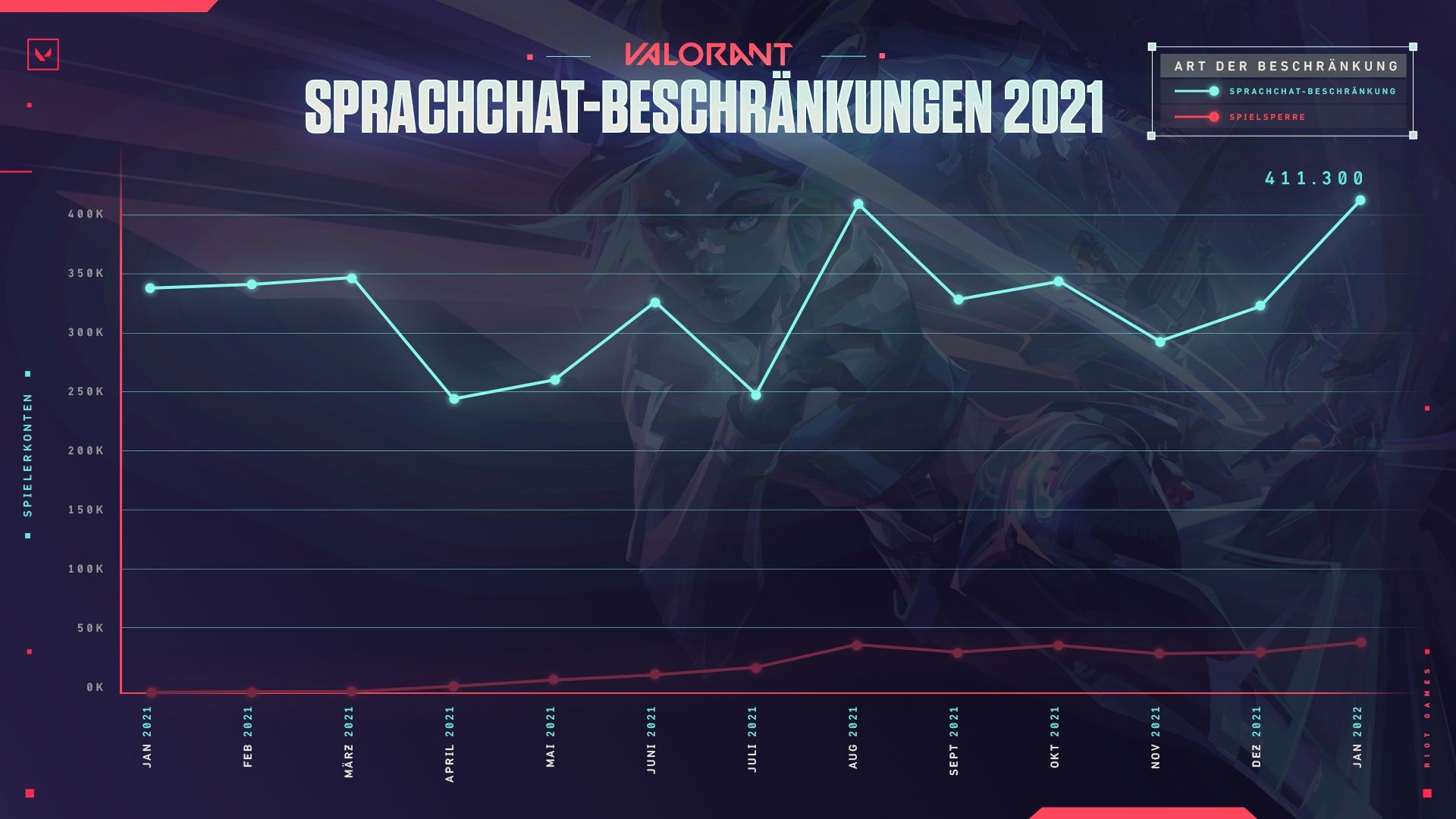

Nehmen wir zunächst Stummschaltungen im Chat, die gewöhnlichste Form der ersten Strafe, die wir für auffällige Text- oder Sprachkommunikation verhängen. Alleine im Januar haben wir mehr als 400.000 Text- und Sprachchat-Einschränkungen in Form einer Stummschaltung verteilt. Diese werden automatisch ausgelöst, wenn ein Spieler etwas im Chat schreibt, das wir als herabwürdigend erkennen, oder wenn sich im Laufe der Zeit (von verschiedenen Spielern in unterschiedlichen Matches) genug Meldungen angehäuft haben, sodass wir ziemlich sicher sein können, dass dieser Spieler den Text- und/oder Sprachchat missbraucht.

Damit sind wir noch nicht am Ziel! Bitte beachte, dass wir immer daran arbeiten, uns zu verbessern und mehr Wörter zu erkennen, die uns momentan durch die Lappen gehen. Das wollen wir in Zukunft noch verbessern.

Spieleinschränkungen

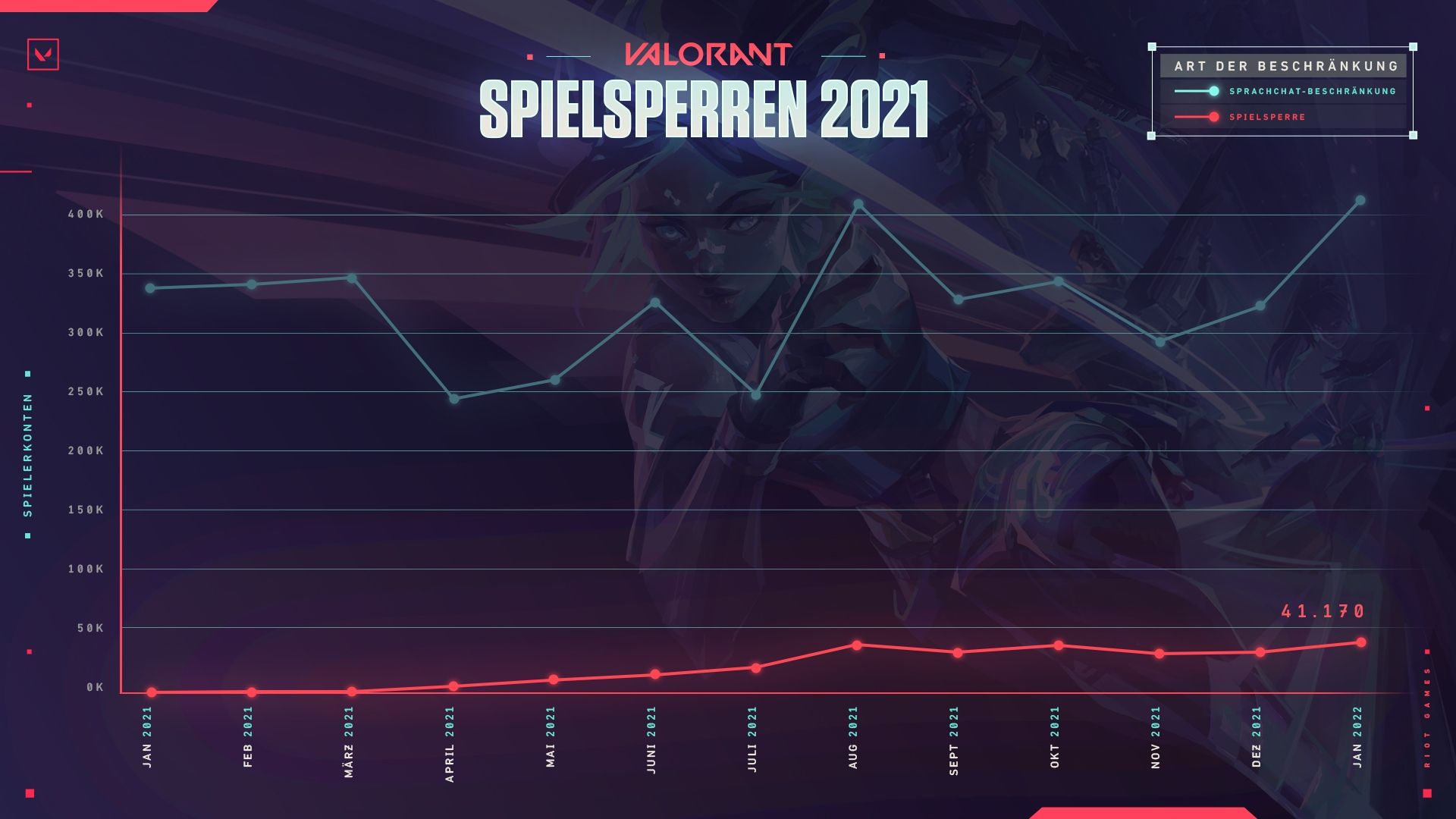

Als nächstes kommen Spieleinschränkungen. Das sind Sperren für Konten, bei denen wir häufig und wiederholt toxische Kommunikation feststellen. Diese Sperren können von ein paar Tagen (für kleinere Vergehen von relativ unbescholtenen Spielern) bis hin zu jahrelang (für Wiederholungstäter) reichen. Permanente Sperren sind für besonders eklatante und/oder wiederholte Vergehen vorbehalten.

Diese Sperren verhängen wir in VALORANT erst seit ungefähr Mitte letzten Jahres (wir wollten sicherstellen, dass die Sperren völlig gerechtfertigt sind). Im Januar haben wir mehr als 40.000 Sperren verteilt.

Was wir noch klarstellen wollen: Die Zahlen oben sind Indikatoren für Verhalten, das wir festgestellt und bestraft haben, aber nicht zwangsläufig Indikatoren dafür, dass Toxizität in VALORANT deshalb abgenommen hat. Als wir Spieler unter die Lupe genommen haben, mussten wir feststellen, dass sich die Häufigkeit, mit der sie auf Belästigungen im Spiel stoßen, nicht maßgeblich verringert hat. Kurz gesagt wissen wir, dass unsere bisherige Arbeit bestenfalls als Grundlage dient und dass wir dieses Jahr und in den darauffolgenden Jahren noch viel zu tun haben.

Wir probieren unterschiedliche Möglichkeiten aus, wie wir im kommenden Jahr mit den Spielern interagieren, sodass wir uns verbessern können. Wir wollen transparent machen, wo wir technisch stehen und wo die Reise hingehen soll, damit wir alle in die Diskussion mit einbeziehen können.

WAS HABEN WIR GEPLANT?

Wie gesagt ist uns klar, dass wir noch viel Arbeit vor uns haben. Also möchten wir dir jetzt zeigen, woran wir gerade arbeiten:

- Allgemein härtere Strafen für existierende Systeme: Für einige der aktuell existierenden Systeme zur Feststellung und Ahndung von Toxizität haben wir uns ziemlich „zurückhaltend“ verhalten, während wir Daten sammelten (um sicherzustellen, dass wir nichts fälschlicherweise erkennen). Mittlerweile haben wir viel mehr Vertrauen in diese Erkennung, also werden wir allmählich das Ausmaß und die Erhöhung dieser Strafen anheben. Dadurch sollten Übeltäter schneller bestraft werden.

- Unmittelbarere Textmoderation in Echtzeit: Momentan haben wir zwar eine automatische Erkennung von „Null-Toleranz-“-Wörtern im Textchat, die daraus resultierenden Strafen treten aber erst nach dem Ende eines Spiels auf. Wir suchen nach Möglichkeiten, Strafen sofort nach dem Vergehen zu verhängen.

- Verbesserungen für die existierende Sprachmoderation: Aktuell verlassen wir uns auf wiederholte Meldungen über einen Spieler, um festzustellen, ob dieser Spieler den Sprachchat missbräuchlich verwendet hat. Missbrauch im Sprachchat ist im Vergleich zum Textchat viel schwerer festzustellen (und umfasst häufig einen manuellen Prozess), aber wir haben Schritte zur Verbesserung unternommen. Anstatt alles geheim zu halten, bis wir glauben, unsere Sprachmoderation ist „perfekt“ (was sie niemals sein wird), werden wir regelmäßig Updates zu den Änderungen und Verbesserungen am System veröffentlichen. Halte Mitte des Jahres die Augen nach dem nächsten Update zu diesem Thema offen.

- Regionales Pilot-Testprogramm: Unser türkisches Team hat vor kurzem ein lokales Pilotprogramm gestartet, um Toxizität in dieser Region besser zu bekämpfen. Kurz gesagt wollen wir eine Meldungsleitung mit Mitarbeitern unseres Spielersupports einrichten (die eingehende Meldungen über Spielerverhalten überwachen) und so anhand etablierter Richtlinien Maßnahmen ergreifen. Das ist noch kein ausgereiftes System, aber wenn es sich als vielversprechend herausstellt, könnte eine Version davon möglicherweise auf andere Regionen ausgedehnt werden.

Wir haben bereits darüber gesprochen, als wir über AFKs diskutiert haben, aber wir möchten unsere Spieler sowohl über die Änderungen als auch die Ergebnisse dieser Änderungen regelmäßiger informieren. So bleiben wir diesem Thema verpflichtet und du bleibst darüber informiert!

NOCH ETWAS ZUM SPRACHCHAT

Wenn einem Spieler gerade im Sprachchat Toxizität widerfährt, wissen wir, wie unglaublich frustrierend das ist und wie hilflos man sich sowohl während des Spiels als auch danach fühlt. Nicht nur untergräbt das all das Gute an VALORANT, sondern es kann nachhaltigen Schaden auf unsere Spieler und unsere Community insgesamt ausüben. Die Feststellung und Bestrafung von toxischem Verhalten im Sprachchat ist eine gemeinsame Anstrengung, die Riot als Ganzes umfasst, und wir arbeiten hart daran, das Spielerlebnis für alle angenehmer zu gestalten.

Sprachauswertung

Letztes Jahr hat Riot seinen Hinweis zum Datenschutz und die Nutzungsbedingungen aktualisiert, um den Sprachchat aufzeichnen und auswerten zu dürfen, sobald störendes Verhalten darin gemeldet wird, und bei VALORANT fangen wir damit an. Ergänzend zu unseren laufenden Spielsystemen müssen wir auch vorher Verstöße gegen unsere Verhaltensrichtlinien zweifelsfrei identifizieren und dokumentieren, damit wir den Betroffenen verständlich mitteilen können, warum ein bestimmtes Verhalten für sie zu einer Sanktion geführt hat.

Momentan visieren wir eine Beta des Sprachauswertungsystems vorerst für Nordamerika/englische Sprache später in diesem Jahr an und werden dann zu einer globaleren Lösung übergehen, sobald wir glauben, dass die Technologie für eine solche Ausweitung bereit ist. Bitte beachte, dass das die ersten Gehversuche mit einer neuen Idee sind. Die Technologie dafür befindet sich noch in der Entwicklung. Es kann also etwas dauern, bis die Technologie ausgereift ist und zu einem effektiven Werkzeug wird. Wir werden dir unsere konkreten Pläne zur Funktionsweise mitteilen, bevor wir beginnen, Daten aus dem Sprachchat in jeglicher Form zu sammeln.

SO KANNST DU HELFEN!

Wir bitten dich, dass du weiterhin die aktuellen Systeme nutzt. Bitte melde weiterhin toxisches Verhalten im Spiel. Bitte verwende die Liste stumm geschalteter Wörter, wenn du auf Dinge stößt, die du nicht sehen möchtest. Und bitte teile uns dein Feedback zu deinen Erfahrungen im Spiel mit und sag uns, was du gerne sehen willst. So kannst du uns helfen, VALORANT zu einem sichereren Spiel zu machen, und dafür sind wir dir sehr dankbar.

Bis zum nächsten Update! In der Zwischenzeit kannst du uns Feedback und Fragen an unser S&PD-Team schicken: